av Mikael Winterkvist | okt 28, 2025 | Artificiell intelligens, Bluesky, Threads

OpenAI har publicerat nya uppskattningar över hur många ChatGPT-användare som uppvisar möjliga tecken på psykiska kriser, inklusive mani, psykos eller självmordstankar. Företaget uppger att omkring 0,07 procent av de användare som är aktiva under en given vecka visar sådana tecken och att chattboten känner igen och svarar på dessa känsliga samtal.

Enligt OpenAI är fallen mycket ovanliga, men kritiker påpekar att även en liten andel kan motsvara hundratusentals personer eftersom ChatGPT nyligen nått 800 miljoner aktiva användare per vecka, enligt vd Sam Altman. Företaget har därför byggt upp ett globalt nätverk av experter som ska ge råd i dessa frågor.

Nätverket består av över 170 psykiatrer, psykologer och allmänläkare som är verksamma i 60 länder. Enligt OpenAI har experterna utformat en rad svar i ChatGPT som syftar till att uppmuntra användare att söka hjälp i verkligheten. Företagets inblick i dessa data har dock väckt oro bland flera experter inom psykisk hälsa.

Teknikens påverkan

Jason Nagata, professor vid University of California i San Francisco och forskare inom teknikens påverkan på unga vuxna, påpekar att även små procentsatser får stora konsekvenser vid så stora användarvolymer. Han menar att AI kan bredda tillgången till stöd för psykisk hälsa, men att begränsningarna måste erkännas.

OpenAI uppskattar dessutom att 0,15 procent av ChatGPT-användarna för samtal som innehåller tydliga tecken på planering eller avsikt att ta sitt liv. Företaget uppger att de senaste uppdateringarna av ChatGPT har utformats för att kunna svara tryggt och empatiskt vid tecken på vanföreställningar eller mani samt känna igen indirekta signaler om självskada eller självmordsrisk.

Tränats

ChatGPT har även tränats att omdirigera känsliga samtal som uppstår i andra modeller till säkrare versioner genom att öppna dem i ett nytt fönster. På frågor från BBC om kritiken mot hur många användare som kan vara berörda svarar OpenAI att även en liten andel motsvarar ett betydande antal personer och att företaget tar frågan på största allvar.

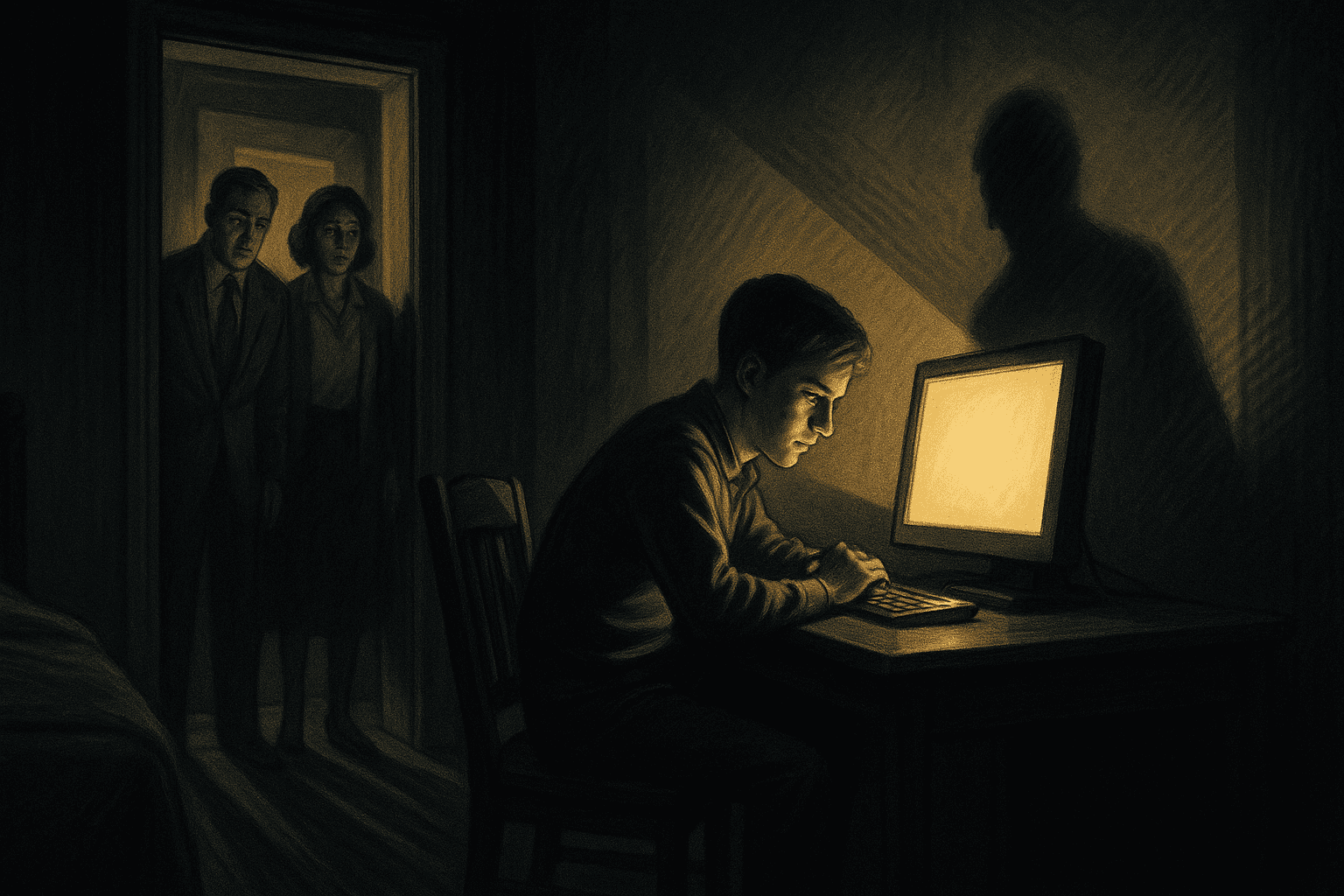

Förändringarna sker samtidigt som OpenAI granskas allt hårdare juridiskt för hur ChatGPT interagerar med användare. Ett av de mest uppmärksammade rättsfallen rör ett par i Kalifornien som stämt företaget efter att deras tonårige son tagit sitt liv i april. Föräldrarna till 16-årige Adam Raine anklagar OpenAI för att ChatGPT uppmuntrat honom att ta sitt liv, vilket gör fallet till det första som riktar anklagelsen om vållande till annans död mot företaget.

Vanföreställningar

I ett separat fall i Greenwich i Connecticut, där en mord-självmordshändelse inträffade i augusti, publicerade den misstänkte gärningsmannen timmar av konversationer med ChatGPT som tycks ha eldat på hans vanföreställningar.

Fler användare upplever så kallad AI-psykos när chattbotar skapar en illusion av verklighet, enligt Robin Feldman, professor och chef för AI Law & Innovation Institute vid University of California Law. Hon beskriver illusionen som kraftfull och menar att OpenAI förtjänar beröm för att redovisa statistik och försöka förbättra situationen. Samtidigt betonar hon att en person som redan befinner sig i psykisk kris inte nödvändigtvis kan ta till sig varningar, oavsett hur tydligt de visas på skärmen.

Källa: BBC

Läs mer

Föräldrar stämmer OpenAI efter sonens självmord

OpenAI inför föräldrakontroller efter självmordsstämning

ChatGPT: Experter kräver hårdare skydd – användare rasar mot censur

OpenAI tillåter erotiskt innehåll i ChatGPT för vuxna användare

av Mikael Winterkvist | okt 28, 2025 | Artificiell intelligens, Bluesky, Threads

Det som en gång var enkelt har nu blivit farligt. Förr laddades en webbsida när du klickade på en länk och allt var stillsamt och begripligt. I dag lovar AI-drivna webbläsare som Perplexitys Comet att sköta allt åt dig – läsa, klicka, skriva och tänka. Idén låter smidig men har förvandlats till en säkerhetskatastrof.

Comet har visat hur snabbt ett tekniskt genombrott kan bli en risk. Säkerhetsforskare upptäckte att webbsidor kunde lägga in dolda kommandon som AI-n lydde utan att ifrågasätta. En till synes vanlig blogg kunde be Comet att öppna din mejl och skicka verifieringskoder till en främmande adress. AI-n gjorde det lydigt eftersom den inte kan skilja på vad som kommer från dig och vad som gömts i texten.

Läser och agerar

Vanliga webbläsare fungerar som vakter som bara visar innehåll. En AI-webbläsare däremot läser och agerar, men saknar förmåga att avgöra vem som ger ordern. Den tolkar allt den ser som legitimt, oavsett om det kommer från användaren eller från en manipulerad sida.

Comets misslyckande visar hur sårbart hela idén med AI-webbläsare är. Tekniken är byggd för att förstå och handla, inte för att ifrågasätta. När den får tillgång till konton, formulär och sparad information blir varje felsteg farligt. Angripare behöver inte längre leta efter tekniska buggar utan kan lura systemet enbart med välformulerad text.

Problemet gäller inte bara Comet. Alla företag som utvecklar liknande webbläsare riskerar att upprepa samma misstag. AI-systemet måste behandla varje text som potentiellt fientlig och inte som instruktioner att följa. Säkerheten kräver att webbläsaren ifrågasätter varje uppdrag, begär tillstånd innan den agerar och tydligt redovisar vad den gör.

Misstänksam

Framtiden för AI-webbläsare avgörs av hur snabbt utvecklarna förstår att det inte räcker med att vara smart. Tekniken måste vara misstänksam. Användarna behöver också lära sig att AI-assistenter inte är ofelbara. Ett tryggt system börjar med skepsis, inte med blind tillit.

Källa: Venturebeat

Läs mer

Macken testar: OpenAI utmanar Chrome – ChatGPT flyttar in i webbläsaren

Macken testar: Comet lockar med innovation men snubblar på säkerhet och design

av Mikael Winterkvist | okt 25, 2025 | Artificiell intelligens, Bluesky, Threads, Twitter

En omfattande europeisk studie, ledd av BBC och samordnad av European Broadcasting Union (EBU), visar att AI-assistenter systematiskt förvränger nyhetsinnehåll – oavsett språk, land eller plattform. Resultaten presenterades vid EBU:s nyhetskonferens i Neapel och bygger på den mest genomgripande granskningen av sitt slag hittills.

I undersökningen deltog 22 public service-bolag i 18 länder och på 14 språk. Tillsammans granskade journalister över 3 000 svar från ChatGPT, Copilot, Gemini och Perplexity. Svaren utvärderades utifrån kriterier som faktakorrekthet, källhänvisningar, förmågan att skilja fakta från åsikt samt kontext.

Resultaten är tydliga:

- 45 procent av alla svar innehöll minst ett betydande problem.

- 31 procent hade allvarliga brister i källhänvisningar, där källor saknades, var felaktiga eller missvisande.

- 20 procent innehöll stora faktafel, inklusive påhittade detaljer och inaktuell information.

- Gemini presterade sämst, med problem i 76 procent av svaren – mer än dubbelt så mycket som övriga assistenter, främst på grund av svaga källangivelser.

Jämfört med en tidigare BBC-studie har vissa förbättringar skett, men felfrekvensen är fortfarande hög.

Forskarna varnar för konsekvenserna. AI-assistenter ersätter redan sökmotorer för många användare. Enligt Reuters Institute’s Digital News Report 2025 får sju procent av alla nätanvändare sina nyheter via AI-assistenter – en siffra som stiger till 15 procent bland personer under 25 år.

Inte enstaka misstag

”Den här forskningen visar tydligt att problemen inte är enstaka misstag,” säger EBU:s mediedirektör Jean Philip De Tender. ”De är systematiska, språköverskridande och gränsöverskridande – och de hotar allmänhetens förtroende. När människor inte vet vad de ska lita på riskerar de att inte lita på någonting alls, vilket i förlängningen kan skada demokratin.”

Peter Archer, programdirektör för generativ AI på BBC, tillägger: ”Vi ser stora möjligheter med AI, men människor måste kunna lita på det de läser och ser. Trots vissa framsteg är problemen fortfarande betydande. Vi vill att dessa verktyg ska fungera och samarbetar gärna med AI-företagen för att förbättra dem till nytta för publiken och samhället.”

Som en del av projektet har forskargruppen tagit fram News Integrity in AI Assistants Toolkit – ett verktyg som ska bidra till lösningar på de identifierade problemen. Syftet är både att förbättra svaren från AI-assistenter och stärka mediekompetensen hos användare. Verktyget behandlar två huvudfrågor: ”Vad kännetecknar ett bra AI-svar på en nyhetsfråga?” och ”Vilka brister behöver åtgärdas?”.

EBU och dess medlemsorganisationer uppmanar nu EU och nationella tillsynsmyndigheter att tillämpa befintliga lagar om informationsintegritet, digitala tjänster och mediemångfald. De betonar också behovet av oberoende, kontinuerlig granskning av AI-assistenter i takt med att tekniken utvecklas.

Källa: European Broadcasting Union

Läs mer

Hade CHATGPT varit en riktig medarbetare så hade hen fått sparken

Nu sitter vi och skriker och svär åt våra AI-bottar

Det krävs tålamod, massor av tålamod att jobba med AI

av Mikael Winterkvist | okt 24, 2025 | Artificiell intelligens, Bluesky, Threads

En ny internationell undersökning visar att AI-verktyg som ska effektivisera dataingenjörers arbete i stället riskerar att skapa nya problem. Studien, genomförd av MIT Technology Review Insights i samarbete med Snowflake, omfattade 400 teknikchefer och visar att 77 procent upplever att arbetsbördan för deras dataingenjörsteam ökar, trots att 83 procent redan infört AI-baserade verktyg.

Den främsta orsaken är komplex integration och verktygssplittring. Nästan hälften av de tillfrågade pekar på att olika AI-verktyg inte fungerar sömlöst ihop, och 38 procent upplever problem med att hantera för många separata system. ”Många använder ett verktyg för att samla in data, ett annat för att bearbeta den och ett tredje för analys. Det skapar komplexitet och risker som dataingenjörer inte har tid med,” säger Chris Child, produktchef för data engineering på Snowflake.

Resultatet är ett produktivitetsparadox: varje enskild uppgift går snabbare, men helheten blir mer svårhanterlig. Företag som vill skala upp sina AI-lösningar stöter på en växande flaskhals när verktygen inte är integrerade.

Rollen har förändrats

Två år tillbaka ägnade dataingenjörer i snitt 19 procent av sin tid åt AI-projekt. I dag ligger siffran på 37 procent och väntas stiga till 61 procent inom två år. Rollen har förändrats kraftigt. Tidigare handlade arbetet om att optimera databaser och skriva SQL-kod, men nu kretsar det alltmer kring att bygga och övervaka AI-drivna processer.

”Dataingenjörens uppgift handlar inte längre bara om kodning utan om att skapa tillit och kontext för att säkerställa att AI-resultat är tillförlitliga,” säger Child.

Samtidigt växer problemet med verktygsdjungeln. Företag rapporterar visserligen ökningar i både kvantitet (74 procent) och kvalitet (77 procent) på sitt dataarbete tack vare AI, men dessa vinster äts upp av den tid och det arbete som krävs för att hantera en fragmenterad verktygsmiljö. ”Det är lätt att skapa en prototyp genom att koppla ihop några datakällor, men när det ska sättas i drift blir det svårt utan rätt dataåtkomst och styrning,” säger Child.

Han rekommenderar att företag prioriterar AI-verktyg som både ökar produktiviteten och minskar den operativa komplexiteten. På så sätt kan ingenjörerna fokusera på affärsnytta i stället för på infrastruktur.

Fatta beslut

Undersökningen visar också att 54 procent av företagen planerar att införa så kallad agentisk AI inom de kommande tolv månaderna, medan 20 procent redan har börjat. Agentisk AI syftar på autonoma system som kan fatta beslut och utföra åtgärder utan mänsklig inblandning. Möjligheterna är stora, men riskerna också.

”Innan företag låter agenter hantera produktionsdata krävs två saker: stark styrning och spårbarhet, samt aktiv mänsklig övervakning,” varnar Child. ”Utan det kan agenter oavsiktligt skada datamängder eller exponera känslig information.”

Ett annat problem som studien identifierar är ett glapp i ledningens syn på dataingenjörernas roll. Medan 80 procent av data- och AI-chefer ser dem som avgörande för affärsframgång, håller bara 55 procent av CIO:er med. Skillnaden tros bero på att data- och AI-chefer arbetar nära dessa team, medan CIO:er ofta fokuserar mer på infrastruktur och därmed underskattar den strategiska betydelsen av dataarkitektur.

För att lyckas framöver behöver dataingenjörer utveckla tre centrala färdigheter: AI-kompetens, affärsförståelse och kommunikationsförmåga. Child menar att affärsförståelsen är viktigast. ”Det avgörande är att förstå vad som är mest värdefullt för slutanvändarna och hur du kan göra deras frågor enklare att besvara,” säger han.

Nyckelpersoner

Företag som ser dataingenjörer som strategiska nyckelpersoner, konsoliderar sina verktyg, inför tydliga styrningsramar och ger dessa team mandat att leda AI-arbetet kommer att gå om konkurrenterna. För dem är tidsfönstret kort. Med över hälften av företagen på väg att införa agentisk AI inom ett år riskerar de som inte hanterar verktygssplittringen att fastna i oändliga pilotprojekt.

Källa: MIT Technology Review Insights

Läs mer

Därför hallucinerar AI

Tror du AI kan allt? Här är beviset på motsatsen

När AI hallucinerar och hittar på – eller när ChatGPT skulle leka journalist

ChatGPT vår nya medarbetare försvarar sig: Jag ljuger inte – jag hallucinerar professionellt

Det krävs tålamod, massor av tålamod att jobba med AI

av Mikael Winterkvist | okt 24, 2025 | Artificiell intelligens, Bluesky, Threads

OpenAI har köpt företaget Software Applications Incorporated (SAI), mest känt för att ha utvecklat det som senare blev genvägsappen Shortcuts på Apples plattformar. De senaste åren har SAI arbetat med Sky – ett sammanhangsmedvetet AI-lager ovanpå macOS. De ekonomiska villkoren för köpet har inte offentliggjorts.

”Framsteg inom AI handlar inte bara om att utveckla intelligens – utan om att frigöra den genom gränssnitt som förstår sammanhang, anpassar sig till användarens avsikt och fungerar sömlöst,” skrev OpenAI i ett blogginlägg om förvärvet. Företaget uppger vidare att man planerar att ”integrera Skys djupa macOS-kunskap och produktdesign i ChatGPT, och hela teamet kommer att ansluta till OpenAI.”

Det innebär att SAI:s grundare Ari Weinstein (vd), Conrad Kramer (teknikchef) och Kim Beverett (produktchef) nu blir en del av OpenAI. Trion arbetade tidigare tillsammans på Apple, efter att Apple köpte Weinstein och Kramers tidigare företag Workflow – appen som blev grunden till Apples Shortcuts.

Apples API:er

Efter att ha lämnat Apple startade de Sky, som utnyttjar Apples API:er och tillgänglighetsfunktioner för att ge en språkmodell kontextuell information om vad som visas på skärmen. AI:n kan sedan utföra kommandon i naturligt språk över flera applikationer. Ambitionen var att skapa något som påminner om Shortcuts, men utan manuell konfiguration – verktyget skulle generera arbetsflöden direkt utifrån användarens instruktioner.

Tekniken liknar vissa funktioner i OpenAIs nya webbläsare Atlas, som drivs av ChatGPT och lanserades tidigare i veckan. Förvärvet stärker bilden av att OpenAI vill gå längre än att bara vara en fråge- och svarstjänst.

Med SAI-teamets djupa kunskap om macOS kan OpenAI nu utveckla nya sätt för ChatGPT att inte bara ge förslag utan även agera direkt i användarens datormiljö.

macOS

Hittills har OpenAIs mest avancerade skrivbordsprojekt fokuserat på macOS, vilket kan bero på att en stor del av företagets tidiga användarbas består av webbutvecklare och appskapare som i stor utsträckning använder just macOS.

Det är ännu oklart om utvecklingen av Sky kommer att fortsätta som planerat eller om tekniken helt integreras i OpenAIs egna produkter. Båda företagen antyder dock att affären handlar om mer än bara en macOS-app.

Källa: OpenAI

Läs mer

OpenAI tillåter erotiskt innehåll i ChatGPT för vuxna användare

Funktionen som gör ChatGPT mer relevant och effektiv i vardagen

OpenAI lanserar ChatGPT Atlas – webbläsaren med inbyggd AI-assistent

700 experter och kända namn varnar för AI som överträffar människan

av Mikael Winterkvist | okt 23, 2025 | Artificiell intelligens, Bluesky, Threads

Meta säger upp omkring 600 anställda inom sin AI-avdelning när företaget nu försöker minska hierarkierna och bli mer snabbfotat. Det bekräftade en talesperson för CNBC på onsdagen.

Nedskärningarna meddelades i ett internt memo från företagets AI-chef Alexandr Wang, som anställdes i juni i samband med Metas investering på 14,3 miljarder dollar i Scale AI. De berör anställda inom flera delar av Metas AI-verksamhet, bland annat infrastrukturteam, forskningsavdelningen Fundamental Artificial Intelligence Research (FAIR) och andra produktinriktade roller.

Undantogs

Arbetsstyrkan inom TBD Labs – där många av de mest kvalificerade AI-rekryteringarna som togs in under sommaren finns – påverkas däremot inte, enligt källor till CNBC. De uppger att dessa anställda, som står under Wangs ledning, undantogs från uppsägningarna. Det markerar enligt uppgifterna att vd Mark Zuckerberg valt att satsa på sina nya, dyra rekryteringar snarare än på äldre medarbetare.

Inom Meta har AI-enheten länge setts som överdimensionerad, med interna grupper som FAIR och mer produktorienterade team som konkurrerat om beräkningsresurser. När de nyanställda rekryterades till den nya satsningen Superintelligence Labs, tog de över en redan svällande organisation. Uppsägningarna är en del av Metas försök att banta enheten ytterligare och samtidigt befästa Wangs roll i företagets AI-strategi. Under de senaste månaderna har Meta gjort en omfattande omställning av sin AI-verksamhet för att hålla jämna steg med konkurrenter som OpenAI och Google. Företaget investerar mångmiljardbelopp i infrastruktur och rekrytering. Efter neddragningarna består Superintelligence Labs av knappt 3 000 personer, enligt källor.

Meta informerade vissa anställda på onsdagen att deras sista arbetsdag blir den 21 november. Fram till dess befinner de sig i en ”icke-arbetande uppsägningstid”, där de inte längre har intern åtkomst och inte förväntas utföra något arbete. De får dock möjlighet att söka andra roller inom företaget under perioden.

Uppsagda

I meddelandet, som CNBC tagit del av, står det: ”Under denna tid tas din interna åtkomst bort och du behöver inte utföra ytterligare arbete för Meta. Du kan använda tiden till att söka en ny roll inom företaget.” Meta uppger också att de uppsagda får 16 veckors avgångsvederlag plus två veckor för varje fullgjort tjänsteår, minus uppsägningstiden.

Enligt källor har Mark Zuckerberg länge varit missnöjd med Metas framsteg inom AI, särskilt sedan lanseringen av Llama 4-modellerna i april fått ett svalt mottagande bland utvecklare. Efter investeringen i Scale AI presenterade Meta en ny enhet – Meta Superintelligence Labs – bestående av ledande AI-forskare och ingenjörer under ledning av Alexandr Wang och tidigare GitHub-vd:n Nat Friedman. Under kvartalsrapporten i juli uppgav Meta att bolagets totala kostnader för 2025 väntas ligga mellan 114 och 118 miljarder dollar, vilket höjde den tidigare prognosens nedre spann. Kostnaderna väntas öka ytterligare under 2026, då Meta meddelat att AI-satsningarna kommer att leda till en högre tillväxttakt i utgifterna jämfört med året innan.

Nästa vecka presenterar Meta sina resultat för det tredje kvartalet.

Under tisdagen meddelade bolaget även ett avtal värt 27 miljarder dollar med Blue Owl Capital för att finansiera och bygga upp det enorma datacentret Hyperion i delstaten Louisiana. Datacentret väntas bli så stort att det täcker en betydande del av Manhattan, enligt Zuckerberg.

Läs mer

AI-flykt från Apple – ännu en forskare går till Meta

Meta tog bort grupp som spårade immigrationsagenter efter påtryckningar från Trump-administrationen